ニュース

オープンウェイトモデルでは最強格の「Mistral 3」が登場 ~Sparse MoEで効率アップ

パフォーマンスを追求した「Large 3」と14B、8B、3Bの小型・高密度モデルを展開

2025年12月3日 15:07

仏Mistral AIは12月3日(日本時間)、同社最新鋭のAIモデル「Mistral 3」を発表した。比較的非力な環境でも動作する3種類の小型・高密度モデル(14B、8B、3B)と、パフォーマンスを追求した「Mistral Large 3」が「Apache 2.0」ライセンスで展開される。

Introducing the Mistral 3 family of models: Frontier intelligence at all sizes. Apache 2.0. Details in 🧵pic.twitter.com/lsrDmhW78u

— Mistral AI (@MistralAI)December 2, 2025

「Mistral Large 3」の特徴は、「Sparse Mixture-of-Experts」アーキテクチャーを採用していること。「Mixture-of-Experts」(MoE)は複数の“専門家”(Expert)モデルを組み合わせ(Mixture)、入力をもとにルーターが最適な“専門家”を選んで出力を合成する仕組みで、全パラメーターを毎回動かす密結合モデルよりも計算量とメモリ使用を抑えられる。これに“専門家”を厳選する(Sparse)工夫を加え、たくさんの“専門家”を協働させたときよりもさらにパフォーマンスを引き出し、効率よく動作できるようにしたのが「Sparse MoE」だという。アクティブパラメーター41B、総パラメーター675Bという規模も相まって、オープンウェイトモデルとしては最高水準のパフォーマンスを発揮する。

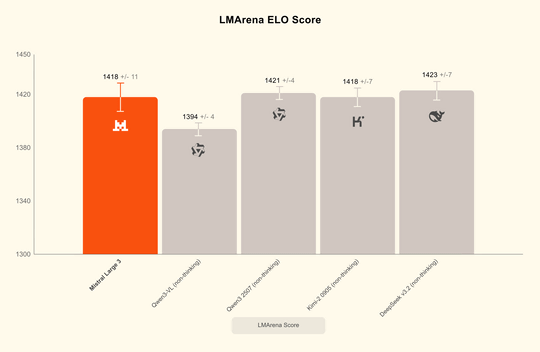

各種テストでも「Mistral Large 3」の優秀さは示されており、「LMArena」のリーダーボードではオープンソースの非推論カテゴリーで2位(オープンソースモデル全体では6位)につける。推論(reasoning)バージョンも近日公開される予定されることなので、そうなればより高いパフォーマンスが期待できるだろう。

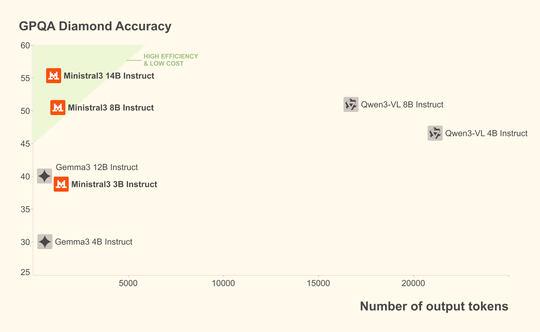

一方、「Mistral 3」の3B、8B、14Bパラメーターモデルは、コストパフォーマンスに優れる多言語対応・マルチモーダルモデルだ。リソースの限られたエッジコンピューティングやローカル用途向けで、各モデルサイズに画像理解機能を備えた「Base」、「instruct」、「Reasoning」の3つのバリアントが提供される。コストを重視する場合は、競合モデルと同等かそれ以上の性能を持ちながら、トークン数がしばしば桁違いに少なくて済む「instruct」、精度を重視する場合はより長く考える「Reasoning」がおすすめのようだ。

「Mistral 3」は現在、「Mistral AI Studio」、「Hugging Face」、「Amazon Bedrock」、「Azure AI Foundry」、「IBM WatsonX」などのプラットフォームで利用可能。近日中に「NVIDIA NIM」や「AWS SageMaker」にも対応する予定だ。

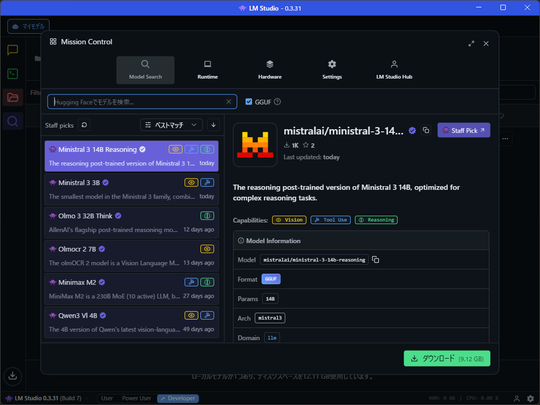

ローカルで利用する場合は「LM Studio 0.3.33」、「Ollama 0.13.1」を使うとよい。

![【Amazon.co.jp限定】1冊ですべて身につくHTML & CSSとWebデザイン入門講座[第2版] (特典:「Webデザイナーのポートフォリオの作り方入門講座」データ配信) 製品画像:2位](https://m.media-amazon.com/images/I/51skMJ-OVcL._SL160_.jpg)