ニュース

ローカルAIを手軽に実行できる「Ollama」プロジェクトに手軽な新アプリ登場、Windows/Mac対応

Llama 3.3やDeepSeek-R1、Phi-4、Gemma 3をローカルで実行

2025年7月31日 11:02

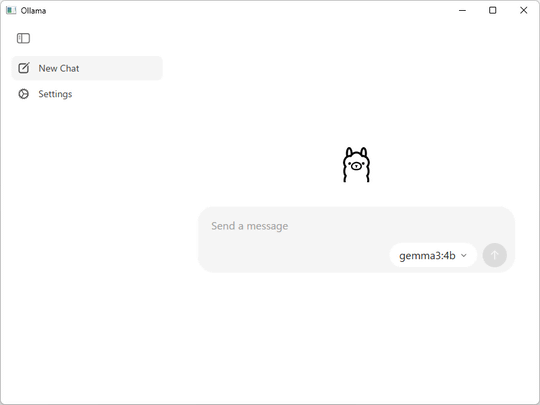

大規模言語モデル(LLM)をローカル実行する「Ollama」に7月30日(米国時間)、Windows/Mac対応の新しいデスクトップアプリが追加された。「GitHub」でホストされているオープンソースプロジェクトで、ライセンスは「MIT」。ダウンロードは無償だ。

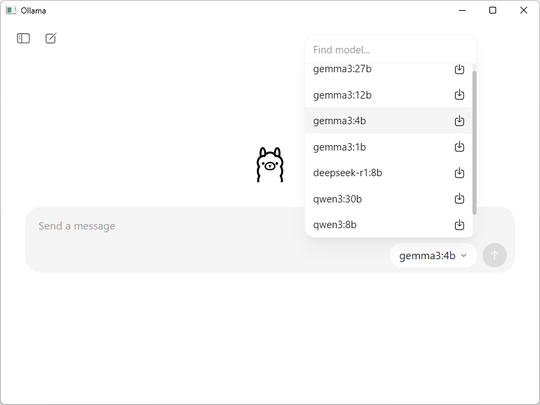

「Ollama」は、「Llama 3.3」や「DeepSeek-R1」、「Phi-4」、「Gemma 3」、「Mistral Small 3.1」といった大規模言語モデルをローカルへダウンロードし、手軽に実行できるようにするソリューション。これまでもコマンドライン(CLI)が利用できたが、GUIアプリならばCLIに苦手意識を持つユーザーにも扱いやすいだろう。

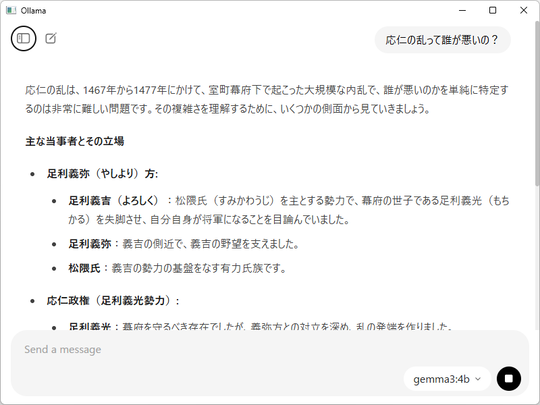

新しいデスクトップアプリの使い方簡単で、入力画面右下のモデルピッカーでAIモデルを選べば、初回利用時に自動でAIモデルがダウンロードされる。ファイルのドラッグ&ドロップにも対応しており、テキストファイルやPDFファイルを用いた推論も簡単だ。

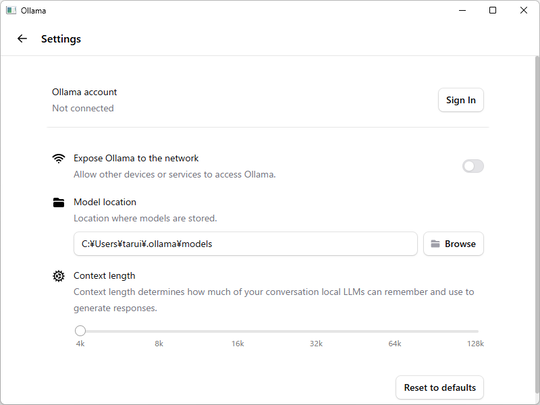

ただし、サイズの大きなドキュメントを処理するためには、「Ollama」のコンテキスト長を増やす必要がある。これは設定画面で簡単に調整できる。コンテキスト長を増やせば、より多くのメインメモリを消費する点にだけは注意したい。

そのほかにも、Google DeepMindの「Gemma 3」などには画像を送信することも可能。これには、「Ollama」の新しいマルチモーダルエンジンが寄与しているという。

Ollama's new app is here for macOS and Windows!

— ollama (@ollama)July 30, 2025

Ollama 0.10!

🧵pic.twitter.com/9J8QfvARKr

ソフトウェア情報

- 「Ollama」

- 【著作権者】

- Ollama

- 【対応OS】

- Windows/Mac/Linux

- 【ソフト種別】

- フリーソフト

- 【バージョン】

- 0.10.0(25/07/18)

![【Amazon.co.jp限定】1冊ですべて身につくHTML & CSSとWebデザイン入門講座[第2版] (特典:「Webデザイナーのポートフォリオの作り方入門講座」データ配信) 製品画像:2位](https://m.media-amazon.com/images/I/51skMJ-OVcL._SL160_.jpg)