ニュース

ローカルAI翻訳モデル「TranslateGemma」を発表 ~2倍規模の「Gemma 3」並みの性能

モバイル・エッジ向けの4B、ノートPCでも動く12B、最高精度の27Bを展開

2026年1月16日 15:20

米Googleは1月15日(現地時間)、「Gemma 3」ベースの新しいオープン翻訳モデル群「TranslateGemma」を発表した。日本語を含む55の主要言語に対応しており、ローカルデバイス上の処理でも高精度な翻訳を実現する。

「TranslateGemma」は、以下の3つのパラメーターサイズで展開される。

- 4B:モバイル・エッジ向け

- 12B:一般的なノートPCで動作

- 27B:最高精度、クラウドGPU/TPU向け

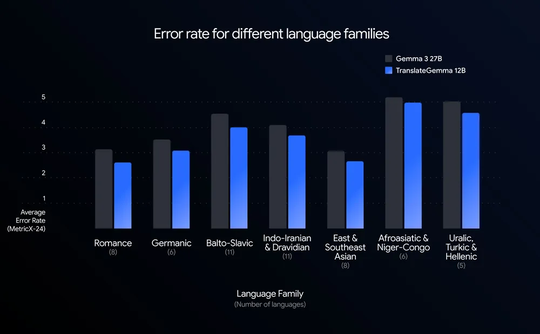

特徴はなんといっても、その効率性だ。「TranslateGemma」は教師あり微調整(SFT)と強化学習(RL)という2段階の微調整プロセスで「Gemini」モデルのもつ『直感』を凝縮しており、12Bモデルでも「Gemma 3」の27Bモデルを上回る性能を叩き出す。4Bモデルも「Gemma 3」の12Bモデルに匹敵し、翻訳だけであれば「Gemma 3」よりも一回り小さいモデルでも同等のクオリティを発揮する。非力なデバイスでも精度を損なうことなく、高いスループットと低遅延を実現できるため、活用の幅が一層広がるだろう。

また、言語のカバレッジ(対応範囲)の大きさも魅力。主要言語だけでなく、約500の追加の言語ペアでトレーニングを行っており、十分なデータがそろっていない言語でも信頼性のある、高品質なパフォーマンスを確保する。「Gemma 3」の強力なマルチモーダル機能も継承しており、特別なマルチモーダル学習なしで画像や音声の翻訳もカバーする。

「TranslateGemma」は現在、「Kaggle」や「Hugging Face」、「Vertex AI」などで提供中だ。

![【Amazon.co.jp限定】1冊ですべて身につくHTML & CSSとWebデザイン入門講座[第2版] (特典:「Webデザイナーのポートフォリオの作り方入門講座」データ配信) 製品画像:3位](https://m.media-amazon.com/images/I/51skMJ-OVcL._SL160_.jpg)