ニュース

Microsoft、小規模言語モデル「Phi-4-multimodal」「Phi-4-mini」を発表

初のマルチモーダル(音声・視覚・言語)対応モデルと、テキスト特化の極小モデル

2025年2月27日 12:23

米Microsoftは2月26日(現地時間)、小規模言語モデル(SLM)である「Phi」ファミリーに「Phi-4-multimodal」「Phi-4-mini」が加わったと発表した。現在、「Azure AI Foundry」、「HuggingFace」、「NVIDIA API Catalog」で利用可能。

小規模言語モデル(Small Language Model:SLM)は、比較的小さなパラメーターで構成された軽量なAIモデル。大規模言語モデル(LLM)に比べて能力は限定されるが、その分サイズを抑えることが可能で、反応が速く、リソースの限られたPC(たとえば携帯性重視のノートPCなど)でも快適に動作する。

Phi-4-multimodal

「Phi-4-multimodal」は、「Phi」ファミリーで初めてマルチモーダルに対応したモデル。音声、視覚、言語をすべて同じ表現空間内で同時に処理することが可能で、異なるモダリティに対応する複雑なパイプラインや個別のモデルは必要ない。

このモデルは「Phi」シリーズの進化形であり、小型パッケージでありながら優れたパフォーマンスを実現する。モバイルデバイスやエッジシステムでも自動音声認識や音声翻訳といった高度なAI機能が必要な場合に役立つだろう。

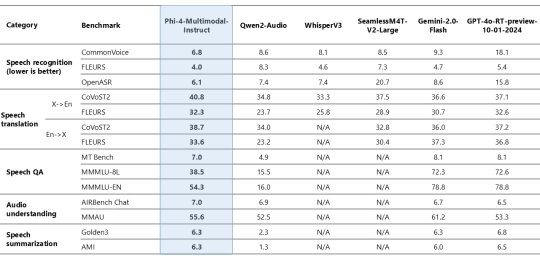

ベンチマークテストでは、音声要約の場合で「GPT-4o」モデルと同等のパフォーマンスレベル、音声質問応答の場合で「Gemini-2.0-Flash」や「GPT-4o-realtime-preview」にやや劣るといった結果だ。わずか5.6Bパラメーターの軽量モデルとしては優秀といえるだろう。文書やチャートの理解、光学文字認識(OCR)、視覚科学的な推論といった一般的なマルチモーダル機能では、「Gemini-2-Flash-lite-preview」「Claude-3.5-Sonnet」などの類似モデルと同等以上の優れたパフォーマンスを発揮する。

![【Amazon.co.jp限定】1冊ですべて身につくHTML & CSSとWebデザイン入門講座[第2版] (特典:「Webデザイナーのポートフォリオの作り方入門講座」データ配信) 製品画像:2位](https://m.media-amazon.com/images/I/51skMJ-OVcL._SL160_.jpg)