ニュース

GPT-4oに迫る日本語能力に強化された「Llama 3.3 Swallow」、東京科学大学などの研究チームが公開

特定のライセンスと利用規約のもとで商用可能

2025年3月13日 14:35

東京科学大学情報理工学院の岡崎研究室および横田研究室、国立研究開発法人産業技術総合研究所の研究チームは3月10日、米Metaの「Llama 3.3」をベースに日本語の能力を強化した大規模言語モデル「Llama 3.3 Swallow」を開発・公開した。モデルはHugging Face上よりダウンロード可能。 Llama 3.3ライセンスに従い、なおかつ米GoogleのGemma利用規約の利用制限に抵触しない範囲において、研究や商用目的などで利用できる。

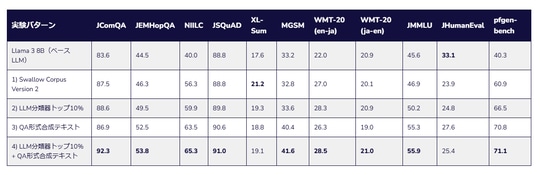

本モデルは、ベースモデルの「Llama 3.3 Swallow 70B v0.4」と指示チューニングモデル「Llama 3.3 Swallow 70B Instruct v0.4」の2種類を展開。どちらのモデルも英語の能力を維持しながら、オリジナルである「Llama 3.3」の日本語能力が強化されている。継続事前学習には、日本語Webコーパス(Swallow Corpus Version 2)、日本語と英語のWikipedia記事、数学およびコーディングコンテンツなどからサンプリングされた約3,150億のトークンが使用された。

ちなみに、本モデルの制約として、Gemma利用規約の利用制限に抵触しない範囲での使用と設定されているのは、学習用合成データに「Gemma 2」(gemma-2-27b-it)が用いられているため。短期間かつ安価に学習データを構築できるよう、高い対話能力を有する既存の大規模言語モデルの応答を模倣するアプローチが採用された。

70Bベースモデルの日本語理解・生成タスクでの性能における平均スコアは「0.629」。これは今回比較されたモデルの中では、GPT-4oの「0.646」に次ぐ2位の成績であり、3位のQwen2.5-72Bの平均スコア「0.623」を上回った(0.6ポイント差)。この結果について研究チームは「GPT-4oに迫る性能と言える」と結論付けている。継続事前学習前のLlama 3.3 70B Instructのスコア「0.601」と比較すれば、日本語理解・生成タスクの平均スコアは2.8ポイントの上昇となった。

また、指示チューニングモデルの場合、日本語MT-Benchでの平均スコアは「0.772」。こちらはGPT-4oの「0.848」やQwen2.5-72B-Instructの「0.835」とは差がつく結果となった。この結果についても研究チームは「人文科学やライティングなど、知識や日本語に関するタスクは得意のようだが、コーディングや数学、推論などで差がついており、改善の余地がありそうだ」としている。

![【Amazon.co.jp限定】1冊ですべて身につくHTML & CSSとWebデザイン入門講座[第2版] (特典:「Webデザイナーのポートフォリオの作り方入門講座」データ配信) 製品画像:2位](https://m.media-amazon.com/images/I/51skMJ-OVcL._SL160_.jpg)