ニュース

Microsoft、「Windows ML」の一般提供を開始 ~アプリへのローカルAI統合を支援

「Windows App SDK」の一部、「Windows 11 24H2」以降を実行する全デバイスをサポート

2025年9月24日 15:36

米Microsoftは9月23日(現地時間)、「Windows ML」の一般提供開始を発表した。「Windows App SDK」(v1.8.1以降)に含まれており、「Windows 11 バージョン 24H2」以降を実行するすべてのデバイスをサポートする。

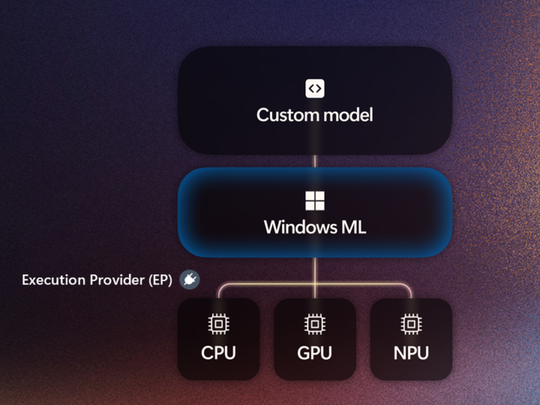

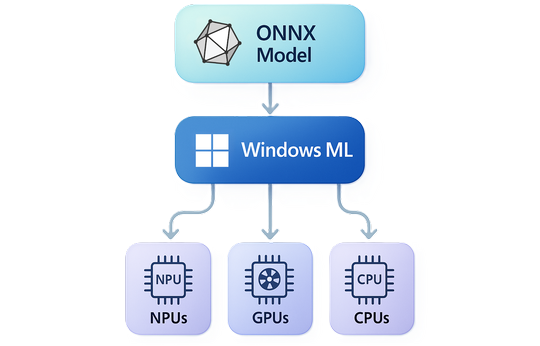

「Windows ML」(Windows Machine Learning)は、「Build 2025」ではじめてお披露目されたローカルAI推論のためのフレームワーク。「DirectML」(DML)を発展させたもので、どのようなハードウェア構成であっても(x64/ARM CPU、GPU、NPU)、それに応じた実行プロバイダー(EP)を自動でダウンロード・管理し、「ONNX」ランタイムを通じてWindows PC上で多種多様なAIをローカル実行できるようにする。

つまり、アプリ開発者はハードウェアの差異を意識しなくても、自分のアプリへAI機能を簡単に取り込めるようになる。また、それぞれのローカルAIに「ONNX」ランタイムをバンドルしなくても、共有ランタイムが利用できるため、ダウンロードサイズやセットアップのコストを削減できるのもメリットだ。

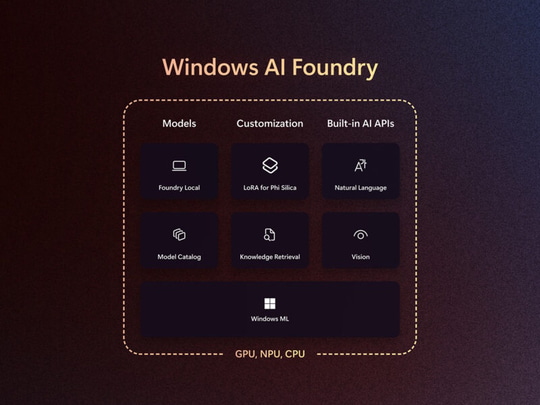

また、「Windows ML」はAI開発の“民主化”を目指す「Windows AI Foundry」の重要なピースのうちの一つでもある。同社の「Azure AI Foundry」でクラウドAIを提供しているが、そのローカル版である「Foundry Local」、ひいては「Windows AI Foundry」を支えるのが「Windows ML」だ。つまり、クラウドAIとローカルAIを適材適所で活用するハイブリッドAIの取り組みの一翼を担う重要なコンポーネントとも言える。

「Windows ML」は、AI開発で広く用いられている「ONNX」ランタイム(ORT)と互換性があり、それに慣れたユーザーであれば比較的容易に移行できる。「Windows ML」はORTとEPの配布・保守を担当し、アプリ開発者をその責任から解放する。新しいAIモデルを試したり、カスタムAIを利用するのも簡単になる(その際は「AI Toolkit for Visual Studio Code」が役立つ)。

また、AMDやIntel、NVIDIA、Qualcommなどが製造するさまざまなチップへの対応も「Windows ML」の役割となる。EPはそれぞれのチップ上で、AIモデルの実行を個別に最適化してくれるので、アプリ開発者はチューニングの知識までは求められない。新しいチップへアプリを対応させるときも、再ビルドは不要だ。NPUで低消費電力を目指したり、高性能なGPUでパフォーマンスを優先するのも、アプリ開発者が選べる。互換性の維持は、Microsoftとチップメーカーが協力して行ってくれる。

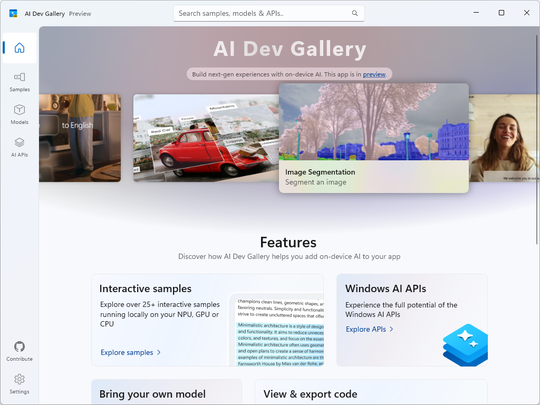

「Windows ML」のパブリックプレビューではAdobeやMcAfee、Wondershareなどのアプリベンダーがテストに参加しており、すでに自社アプリに「Windows ML」でローカルAI機能を統合しているとのこと。「Windows ML」でカスタムAIモデルと対話するサンプルは「AI Dev Gallery」アプリ(プレビュー版)で試すことができる。

![【Amazon.co.jp限定】1冊ですべて身につくHTML & CSSとWebデザイン入門講座[第2版] (特典:「Webデザイナーのポートフォリオの作り方入門講座」データ配信) 製品画像:3位](https://m.media-amazon.com/images/I/51skMJ-OVcL._SL160_.jpg)