ニュース

OpenAI、PCで動くローカルAI「gpt-oss」を発表、「o4-mini」相当のモデルなど

オープンウェイト推論モデル、「Apache 2.0」ライセンスで利用可能

2025年8月6日 09:54

米OpenAIは8月5日(現地時間)、「gpt-oss-120b」および「gpt-oss-20b」をリリースした。事前学習済みAIモデルで“重み”(Weight)と呼ばれるパラメーターを公開し、誰でも自由に利用できるようにした“オープンウェイト”の推論モデルで、「Apache 2.0」ライセンスのもと利用できる。

gpt-oss is out!

— Sam Altman (@sama)August 5, 2025

we made an open model that performs at the level of o4-mini and runs on a high-end laptop (WTF!!)

(and a smaller one that runs on a phone).

super proud of the team; big triumph of technology.

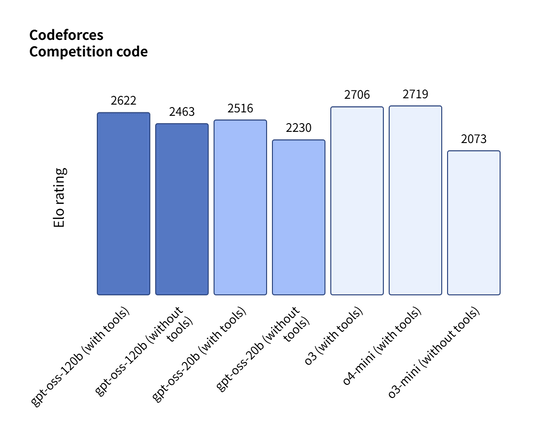

「gpt-oss-120b」は「OpenAI o4-mini」とほぼ同等の能力を持つにもかかわらず、単一の80GB GPU環境におさまるのが特徴。一方の「gpt-oss-20b」はさらに軽量で、わずか16GBのメモリしかないエッジデバイスでも実行できる。パフォーマンスは「OpenAI o3-mini」と同等だ。

- gpt-oss-120b:NVIDIA製GPU「H100」1枚におさまる。プロダクション環境、高推論ユースケース向け(117Bパラメータ、5.1Bアクティブパラメータ)

- gpt-oss-20b:低レイテンシ、ローカルまたは特殊なユースケース向け(21Bパラメータ、3.6Bアクティブパラメータ)

「gpt-oss」は関数呼び出しやWebブラウジング、Pythonツール呼び出しといったエージェント機能も備えており、モデルの推論プロセス「思考の連鎖」(Chain-of-Thought)にフルアクセスして出力を改善することもできる。

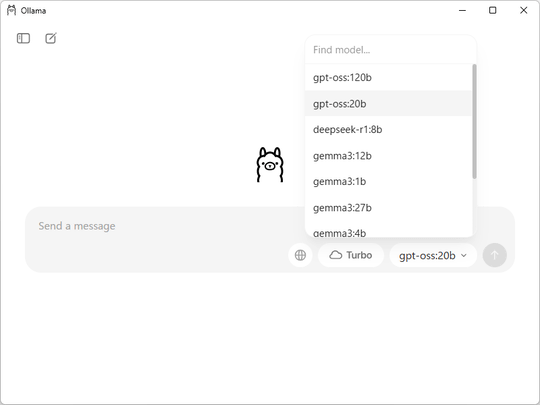

「gpt-oss-120b」「gpt-oss-20b」のウェイトは、「Hugging Face」などから無料でダウンロード可能。Microsoftからは「gpt-oss-20b」モデルのGPU最適化バージョンがWindowsデバイスに対して提供される。「Foundry Local」や「Visual Studio Code」のAIツールキットを用いれば、手軽にローカル推論が行える。「LM Studio」などとも協力しているとのことで、先日リリースされたばかりの「Ollama」デスクトップアプリでも簡単に利用できる。

![【Amazon.co.jp限定】1冊ですべて身につくHTML & CSSとWebデザイン入門講座[第2版] (特典:「Webデザイナーのポートフォリオの作り方入門講座」データ配信) 製品画像:2位](https://m.media-amazon.com/images/I/51skMJ-OVcL._SL160_.jpg)