特集・集中企画

「事前学習はやり直しのできない一発勝負」 国産フルスクラッチLLM「PLaMo」シリーズ開発者に独占インタビュー

最新「PLaMo 2」の登場が国産AIの潜在力を世界に示す新たな一歩に

2025年4月16日 09:00

2025年2月25日、(株)Preferred Networksは、フルスクラッチで独自開発した大規模言語モデル「PLaMo」シリーズの最新モデル「PLaMo 2 8B」を公開した。ChatGPTやGeminiなど海外の生成AIが話題になっている中、「PLaMo」シリーズは日本語に特化した高性能AIモデルとして注目を集めている。

今回、独占インタビューとして、「PLaMo 2」誕生の経緯や技術的な特徴、今後の展望などについて、開発者の一人であるエンジニアの今城健太郎氏にお話を伺った。

当初は、LLMの開発はしない、という流れだった

Preferred Networks(以下、PFN)は、2014年に設立された日本を代表するAI開発企業。「現実世界を計算可能にする」をミッションに掲げ、生成AIや深層学習、ロボティクスなどの最先端技術を活用して、医療、交通、製造業といった幅広い分野でイノベーションを推進している。

今回、「PLaMo 2」の開発をリードした今城氏は、学生時代に情報オリンピックを経験し、競技プログラミングの会社を友人と立ち上げるなど高度なプログラミングスキルを身につけており、Google在籍時には「Google Maps」や「Google Play」のチームでエンジニアとして働いていた。まだディープラーニングが一般的でなかった時代から機械学習に関心を持ち、2018年にPFNへ移籍した経歴を持つ。

2022年11月に「ChatGPT」が登場し、世界に大きなインパクトを与えた。今城氏も初めて触れたときにとても感動したという。それまでの機械学習では、入出力のペアを与えれば、それに関しては対応できるが、それ以外はできない、というのが常識だったのに、ChatGPTは学習していない内容でも対応するのが革命的だった。

ChatGPTは計算機を使えば使うほど性能が上がるので、だったらお金さえ投資すれば人類が大きく進歩するのではないか、と夢を見ました。(今城氏)

PFNの社内にも自然言語処理を研究している人物はたくさんいたものの、扱いが難しく、ChatGPTが出るまではあまり注力していなかったそう。また、LLMを開発するには膨大な計算資源と大きなコストが必要になるため、当初は、LLMの開発はしない、という流れだった。

しかし、今城氏は日本主導のLLMを開発するべきだと考えた。例えば、アメリカのChatGPTでも、中国のDeepSeekでも、海外主導のAIモデルだと英語圏や中国圏のルールやポリシーに左右されてしまうためだ。日本はOKなものも、アメリカのルールでNGであれば、使えなくなってしまう。今城氏がGoogleで働いていたときも、例えば、Google Playで公開するアプリの審査をするときにそのようなルールを目の当たりにしてきたという。

他国のルールでダメだとなるなら、せっかくの自由度が減ってしまいます。それだったら日本国内でいろんなことができるといいな、と考え、日本のLLMを開発したいという気持ちを持っていました。(今城氏)

そこで、経産省やNEDO(国立研究開発法人新エネルギー・産業技術総合開発機構)から支援を受け、開発をスタートすることになった。開発方針は、英語圏の文脈に最適化された海外モデルをただ真似るのではなく、あくまで日本語のデータをしっかりと使い、日本特有の表現や文化的背景にも対応できるようにすることを重視した。日本の商習慣や法律、企業名、地名なども確実に反映するモデルを目指すという取り組みが、PLaMoプロジェクト誕生の鍵になったのだ。

事前学習は、基本的にやり直しできず、一発勝負になる

PLaMoの開発は、まずWeb上の膨大なテキストで構成されたデータセットを整理し、それを事前学習でモデルに学ばせるフェーズから始まる。LLMを開発する際は、Common Crawlという非営利団体が作っているデータセットを使うことが多いが、PFNでもそのデータを活用した。もちろん、膨大なWebデータから不要なコンテンツを除外するフィルタリング作業が徹底的に行われた。

Webデータを闇雲に全部入れるわけではなく、なるべく綺麗な形で整形して学習させるのがキモです。また、日本語のコーパスを大きくしているのに加えて、ページのタイトルや日付などを決まった形式でタグ付けするなど整形して学習させています。そうするとLLMが学習中に情報を活用しやすくなり、性能が上がりやすくなります。(今城氏)

小型のLLMの場合、そのLLMで何をしたいのかによって学習させるデータを用意する方が効率が上がるという。例えば、翻訳をするのであれば翻訳に関するデータが適しており、医療に使うなら医療のデータが必要になる。特に、コーディングの性能は、コーディング用のデータを入れると明確に性能が向上するそうだ。

PLaMoには特に金融のデータを入れているという。例を挙げると、日銀が出している資料などはきちんと学習させている。やみくもに学習させて、たまたま入っていたというのではなく、網羅的に整理して入れることで、その領域のレスポンスを向上させているのだ。

開発は、さくらインターネット(株)が提供する大量の高性能GPU「NVIDIA H100」を使用。計算資源の9割はこの事前学習に費やしたそう。事前学習の時点でLLMが身に付けた潜在能力以上のものは、そのあとにどう頑張っても引き出すことが難しいからだ。そして、この事前学習には数カ月かかるため、基本的にやり直しはできず、一発勝負になる。

同時に、味付けとも呼ばれる事後学習にはあまりコストをかけないという判断を早々に下した。OpenAIのように大規模な人手評価を行うには莫大な費用や人材が必要になるためだ。

プロジェクト開始から約半年後の2023年9月28日に、日英2言語対応のLLM「PLaMo 13B」が公開された。13Bという標準的なGPUサーバーでも利用できるサイズながら、当時、日英2言語のベンチマーク評価で世界トップレベルの性能を実現した。この「PLaMo 13B」は、研究・商用利用が可能なライセンス(Apache License v2.0)で公開されている。

その後、データをさらに整理した1,000億パラメーターの「PLaMo 100B」の開発がスタート。NEDOが行っている国内の生成AIの開発力を強化するためのプロジェクト「GENIAC」の第1サイクルに採択されたものだ。

PLaMo 13Bのときは、とりあえず1回学習させてみましょう、という実験段階のようなものでした。PLaMo 100Bを作るときは、余裕はあまりなかったのですが、可能な限り当時の研究を参考にして、入れるデータと入れないデータをフィルタリングし、学習させました。(今城氏)

「PLaMo 100B」は2024年6月に完成し、日本語性能を評価するベンチマーク「Jaster」において、GPTやClaude、Llamaを上回る性能をたたき出した。また、狙い通りに金融分野関連のベンチマークや医療などの専門知識に関する応答にも優れていることがわかった。「PLaMo 100B」の事前学習モデル「PLaMo-100B-Pretrained」は、学術・研究用途を想定した非商用ライセンスと商業用途向けの商用ライセンスで提供されている。

国産のLLMというと、ほかにもいくつか登場しているが、PFNの強みはAI開発に関わる人数が多いことが挙げられる。人数が多いほど、試行錯誤できる量が増えるので、そこがアドバンテージになっているとのこと。

うちの会社は、高速化や最適化が好きな人が多いので、そこで強みを出しています。(今城氏)

世の中でモノを動かして価値を生んでいるのは昔ながらのコンピューター

PLaMoのいわばシリーズ1の成功を受け、次世代PLaMoである「PLaMo 2」の開発がスタートした。

こちらも「GENIAC」の第2サイクルに採択されている。このときは、いろいろと余裕が出てきており、AIモデルのアーキテクチャーを独自開発した。独自開発の例としては、「トークナイザ」というLLMの基盤となる文章を単語や文字といった最小単位に分割するツールを作り直した。

トークナイザで文章を区切って処理するときに、LLM用の語彙リストのようなものを使います。大体、どこも10万語彙くらい持っているのですが、その割り振りが結構キモになります。当然、OpenAIなどは日本語の割合がかなり少ないのですが、それに対して、PLaMoは半分ぐらいが日本語なので、日本語の処理効率が高くなるのが強みです。(今城氏)

また、LLMで生成したデータを学習させているのも特徴だ。その頃は、メジャーな手法ではなかったのだが、金融やQ&Aといった領域の精度を上げるために今城氏が取り入れたという。

うちの会社にはチャレンジする社風があります。その当時も、言語を学ばせるのだから、人間が書いた言語を入れないとよくないと言われていましたが、とにかくパフォーマンスを向上させたいから、合成データでも何でもチャレンジ的に入れてみることにしました。最初からそのチャレンジができたのはすごくよかったと思います。(今城氏)

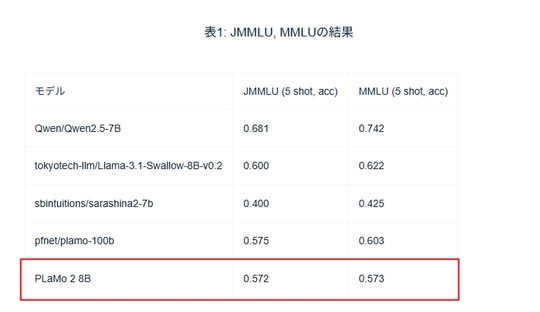

まずは予備実験として、10億パラメーターの「PLaMo 2 1B」を作り、2025年2月、80億パラメーターを持つ「PLaMo 2 8B」を発表した。比較的コンパクトな規模ながら、従来の1,000億パラメーター(100B)級と遜色ない性能を実現している。

海外製のAIでも同じなのですが、8Bのモデルが以前の100Bのモデルを超えるベンチマークスコアを出すようになるというのは、本当にAIアーキテクチャーの進化が速くて驚きます。(今城氏)

「PLaMo 2 1B」はオープンソースで公開されており、「PLaMo 2 8B」のライセンスは条件付きで商用利用可能な「PLaMo Community License」。ともに「Hugging Face」からダウンロードできるようになっている。個人や中小企業の試用ハードルを下げると同時に、大企業向けの商用ライセンスも用意している。

PLaMoシリーズをめぐるビジネスモデルにはいくつかのパターンがあるという。

「PLaMo 2 8B」のような小さなAIモデルを上手に使うことが大事だと考えています。もちろん大きいAIモデルは能力が高いですが、8Bくらいだと追加の味付けなどすごく簡単です。実行する際も10分の1のメモリで済みます。そこで、コーディングや翻訳などの専門モデルを複数作って、自分たちがやりたいことに合わせて柔軟に使う方が活用が広がると思っています。(今城氏)

さらには、ビジネスモデルとして、AIモデル自体を提供することも考えているとのこと。

企業によっては、手元で動かしたいというニーズがあるので、差別化になることは間違いない。企業や研究機関が独自データを使ってファインチューニングする際の技術サポートを行うこともできる。また、PFN側であらかじめ特化モデルを仕上げておき、金融や医療など汎用性のある領域に対してはそれらを販売するという手法も検討しているそうだ。

チャットは人間フレンドリーでよいのですが、世の中でモノを動かして価値を生んでいるのは昔ながらのコンピューターです。人間の言葉を解釈し、そのコンピューターに橋渡しするところをアプリケーション化して生産性を高めたいと考えています。(今城氏)

PLaMoプロジェクトは、この先もアップデートを繰り返しながら進化する見通しだ。LLMは継続的に学習を積み重ねることが性能向上の要と言われるが、PFNでも定期的に次世代モデルを学習していく計画があるそう。もちろん「PlaMo 3」も開発する予定とのことだ。

「PLaMo 2」の登場は、国産AIの潜在力を世界に示す新たな一歩

世界が注目する生成AIの技術競争において、PLaMoシリーズは軽快さと日本語理解の強さを武器に、独自の地平を切り拓こうとしている。

やがてテキストを超えたマルチモーダルや自動化領域にも波及すれば、そのインパクトはさらに広がるはずだ。「PLaMo 2」の登場は、日本国内の技術革新にとどまらず、国産AIの潜在力を世界に示す新たな一歩となるだろう。

著者プロフィール:柳谷 智宣

IT・ビジネス関連のライター。キャリアは26年目で、デジタルガジェットからWebサービス、コンシューマー製品からエンタープライズ製品まで幅広く手掛ける。近年はAI、SaaS、DX領域に注力している。日々、大量の原稿を執筆しており、生成AIがないと仕事をさばけない状態になっている。

・著者Webサイト:https://prof.yanagiya.biz/

![【Amazon.co.jp限定】1冊ですべて身につくHTML & CSSとWebデザイン入門講座[第2版] (特典:「Webデザイナーのポートフォリオの作り方入門講座」データ配信) 製品画像:2位](https://m.media-amazon.com/images/I/51skMJ-OVcL._SL160_.jpg)